White-Hat SEO: dallo stupido all'esoterico

The revised celestial monochord (University of Glasgow Library, da Flickr)

Quanto spiego agli 'addetti ai lavori' i metodi che utilizzo per il SEO, invariabilmente ottengo due reazioni; qualcuno mi giudica eccessivamente 'esoterico' per i metodi che sono un po' differenti della media e altri mi considerano un inguaribile ingenuo, conoscendo altri metodi che con molto meno sforzo portano agli stessi, o migliori, risultati. Penso che in linea di massima, fatte le opportune tare, la differenza possa essere ricondotta a quella tra le tecniche 'pulite' (white hat) e quelle... un po' meno pulite (black hat).

Non penso che esistano tecniche 'giuste' e 'sbagliate', ma modi diversi di vedere lo stesso cielo, così come agli albori della scienza la disputa sull'armonia del cosmo tra Keplero e Fludd infiammava il dibattito.

Sappiamo chi ha vinto; molti sanno chi fosse Keplero, nessuno o quasi chi sia Fludd.

Che abbiate il cappello bianco, o quello nero, vi invito a leggere i miei metodi SEO; se volete sapere come la penso, riferitevi all'immagine qui sopra.

Pensare alla visibilità di un sito va oltre la posizione nella SERP (la posizione dei risultati di ricerca) per qualche keyword; in questa pagina cercherò di spiegare i metodi con i quali analizzo la situazione dei siti e consiglio le strategie per migliorarne il posizionamento.

Naturalmente non si parla di black-hat SEO, cioè di tecniche 'sporche', ma si parla soprattutto di analisi della situazione corrente in base alla quale proporre soluzioni utili.

Per prima cosa vorrei ribadire, nel caso fosse ancora necessario, che non ha senso pensare alla visibilità di un sito per una singola keyword; ciò che mediamente interessa al mio cliente è essere ricercato per un concetto, sia esso espresso con una keyword o con un'altra.

In questo modo, infatti, si ottiene un effetto a catena: Google posiziona bene siti che dimostrano di avere contenuti 'vasti' sull'argomento, cioè più pagine relative allo stesso argomento.

Già, in passato, un articolo (Google capisce le differenze?) riguardava proprio le differenze tra minime variazioni di keyword, per verificare se Google sia o meno sensibile a piccoli cambiamenti quali singolare/plurale o minime variazioni sintattiche; la conclusione: "Nel definire le strategie di promozione SEO quindi, penso sia bene tenere in conto tutte le varianti di una keyword, e non esaurire la promozione utilizzandone una sola variante 'sperando' che poi Google, 'intelligente' com'è, riesca comunque ad indicizzare il contenuto".

Oggi ci spingiamo un po' oltre, cercando di definire a priori un concetto e quindi analizzarne da una parte la risposta del sito in analisi e dall'altra le strategie di promozione.

Esistono infatti molti tool che evidenziano la validità di una pagina nei confronti di una singola keyword; il 'page grader' di Moz è quello che utilizzo più spesso a questo scopo.

Risulta invece più difficile riuscire a capire come risponde il sito ad un concetto o argomento. Per farlo dobbiamo quindi meglio specificare cosa si intenda, da questo punto di vista, per concetto; più che definirlo dal punto di vista semantico, immaginiamo di poter definire un concetto con un gruppo di keyword che, prese nel loro insieme, definiscano il concetto stesso.

E' chiaro che nella definizione delle keyword per il concetto verranno utilizzati più strumenti; potrebbe essere utile utilizzare:

- lo strumento di pianificazione delle parole chiave di Adwords (frequenza / concorrenza)

- uno strumento per la ricerca di sinonimi

- uno strumento per verificare cosa suggerisce Google Instant

- una intervista (indispensabile!!!) al proprietario / gestore del sito per acquisire conoscenza della materia e parole associate

- una ricerca su Google per vedere quali siti, mediamente, rispondono.

A questo punto avremo organizzato il nostro concetto come lista di parole. Per quella che è la mia esperienza, ho utilizzato un minimo di dieci e un massimo di circa 50 parole per la definizione del concetto, tenendo conto che la vicinanza tra di esse deve essere proporzionale a quanto precisamente il concetto va definito.

Cioè se il sito serve a promuovere, ad esempio, un servizio finanziario, le keyword riguarderanno lo specifico servizio; mentre se lo scopo è promuovere una serie di servizi finanziari le keyword saranno, forzatamente, più distanti semanticamente. Nel primo caso avremo un cuneo affilato per una ricerca specifica di settore, nell'altro un cuneo dall'angolo più ampio ma di larghezza superiore per ottenere risultati meno precisi ma più vasti in un ambiente più diffuso.

Bene, ho definito il concetto. Che me ne faccio di queste keyword?

E' ora di cominciare a... muovere le mani, o meglio, la tastiera.

Innanzitutto bisogna collezionare, per ognuna delle keyword, la SERP, ovvero il posizionamento che ne dà Google, eseguendo una ricerca che restituisca x risultati per ognuna.

Tipicamente utilizzo valori tra 30 e 100 risultati; su Google basta aggiungere &num=x all'URL per ottenere un numero specifico di risultati (fino a 100).

Alcune avvertenze:

se utilizzate il vostro browser per fare questa indagine, i risultati saranno forzatamente influenzati:

1) dalla vostra storia su Google

2) dalla localizzazione del vostro browser

Esiste il modo di ottenere risultati un po' più anonimi regolando i 'settings' di Google, oppure utilizzando le API; attenzione però che Google è molto sensibile ai tentativi di 'scraping' e potrebbe bannare presto le vostre ricerche se fatte in modo programmatico.

Ci sono più sistemi per ottenere queste liste.

a) il semplice componente del browser che 'grabba' tutti i link della SERP di Google e ve li trasforma in XLS/CSV

b) siti appositi che eseguono tutta l'operazione

c) programmi installabili

d) classi di programmazione da inserire nei vostri script

Le ho utilizzate tutte, ognuna ha pregi e difetti, il risultato sarà comunque un elenco di siti classificati a seconda della keyword ricercata e della posizione nella SERP.

Ad esempio cercando 10 keyword per la profondità di 80 risultati otterrete 800 link, sui quali eseguire analisi a tre livelli:

1) direttamente sull'insieme URL - KEYWORD - POSIZIONE, cioè un'analisi generale di posizionamento

2) scaricando gli 800 documenti che vanno a definire un corpus di documenti sui quali

2a) eseguire analisi lessicali

2b) eseguire l'analisi dei parametri tecnici

3) Analisi delle correlazioni parametriche tra i dati trovati nei punti di precedenza ed il posizionamento

4) Analisi dei link, per l'eventuale ricerca di siti importanti da linkare o sui quali chiedere di essere ospitati con un backlink.

.

1 - Analisi generale di posizionamento

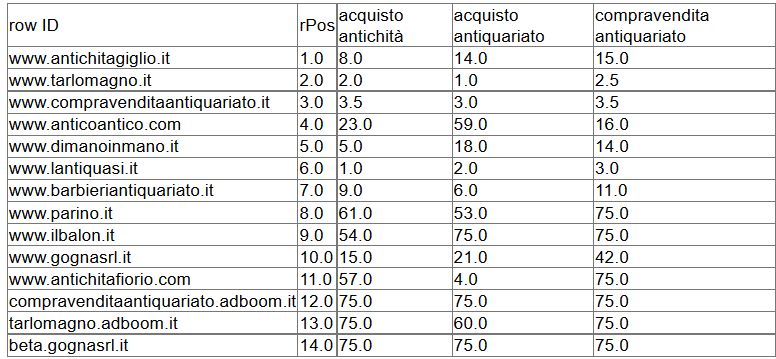

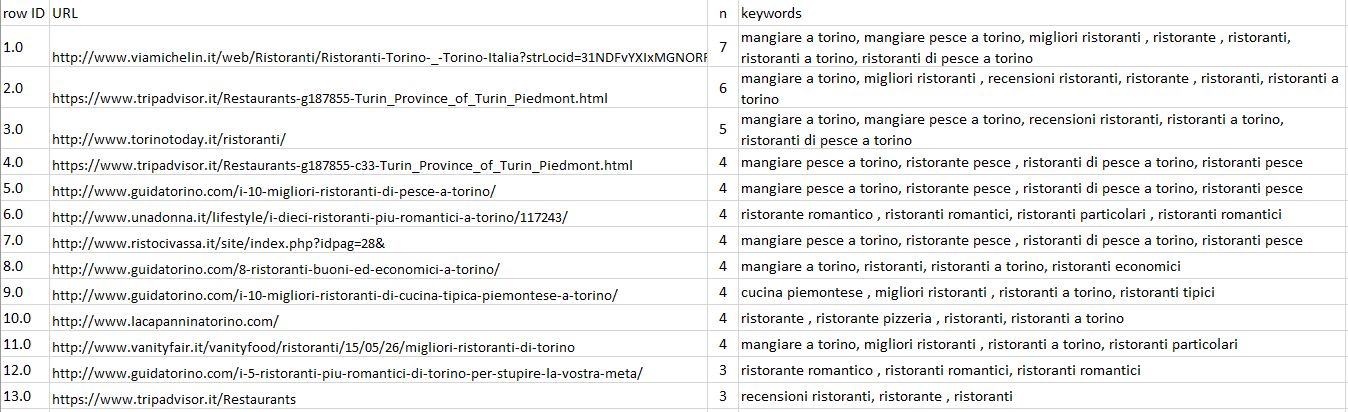

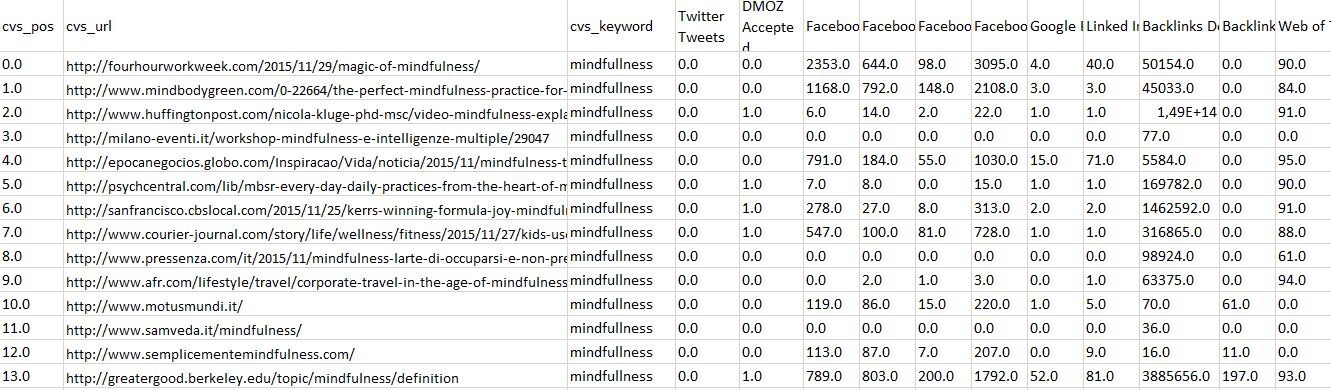

Per eseguirla è sufficiente la tabella con i posizionamenti. Partendo dall'esempio precedente, avremo una tabella con 800 righe e tre colonne: posizione nella SERP, indirizzo rilevato, keyword.Ecco un esempio:

La tabella può essere agevolmente trattata spostando su una diversa colonna ogni risultato relativo ad una distinta keyword, in modo da ottenere una tabella di questo tipo (esempio da altra ricerca):

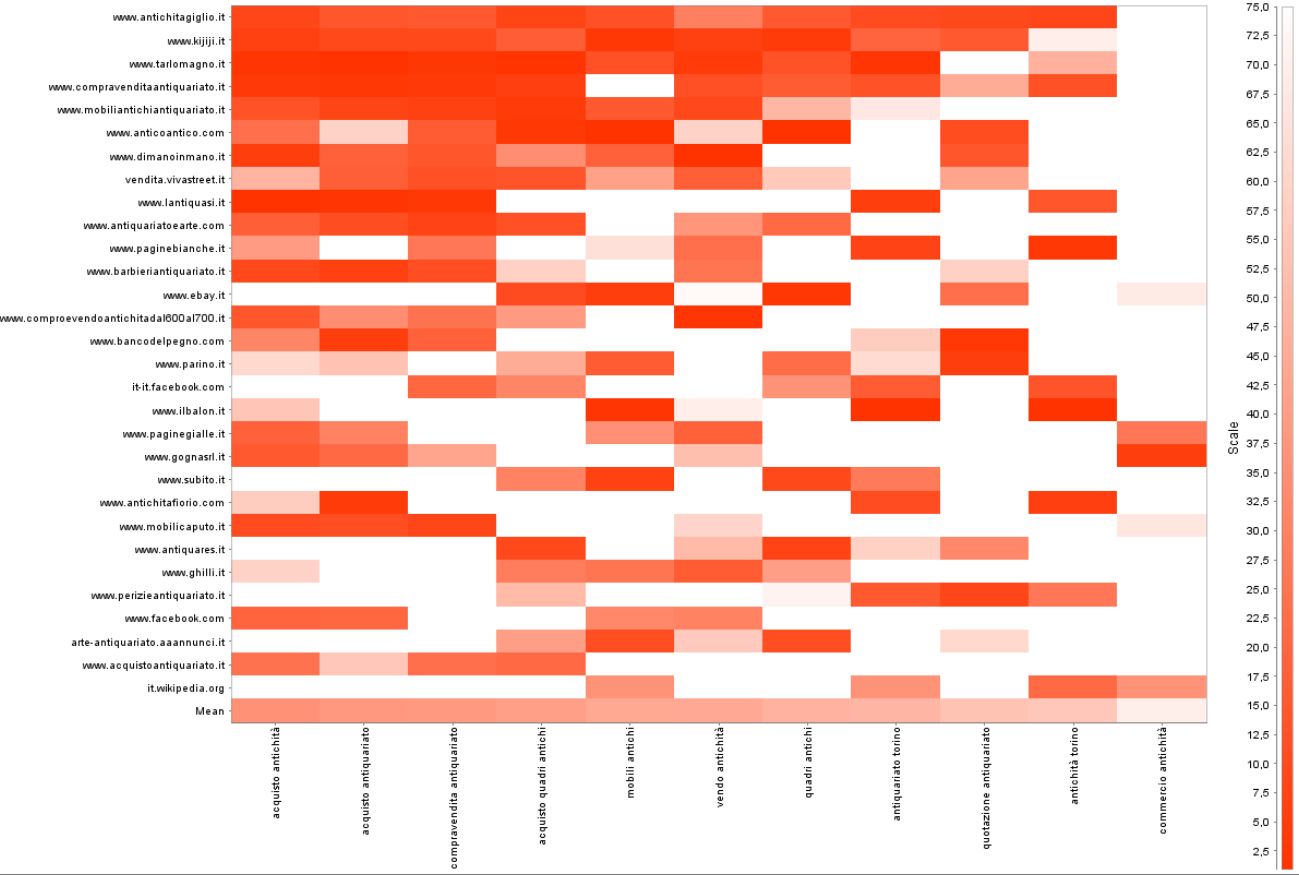

A questo punto ciò che normalmente eseguo è la costruzione di una heatmap, utile a visualizzare più concetti:

Come si vede, ad ogni valore è associata una gradazione di rosso; quando il rosso è più acceso vuol dire che in quella corrispondenza sito/keyword il posizionamento è vicino alla prima posizione, viceversa quando scolorisce vuol dire che ne è lontano; quando è bianco è al di fuori della SERP per la profondità considerata, nel caso in esempio 75 risultati.

I dati che possiamo raccogliere:

1) a colpo d'occhio si può vedere quanto i siti si differenzino l'uno dall'altro; nel caso di heatmap più o meno uniformemente colorato la competizione è molto forte, viceversa se i colori sono raccolti in una sola zona la competizione è più aperta. Inoltre se un sito occupa un'intera riga vuol dire che, per questa serie di keyword, risponde molto bene ed è un ottimo competitor per il concetto che ci interessa.

2) ordinando i siti a seconda della media delle posizioni SERP che assume per le keyword, otteniamo una scala dall'alto al basso dei siti mediamente meglio posizionati per il concetto analizzato; in questo caso vengono filtrati i primi 30 risultati.

Una successiva tabella, che qui non riporto, confronta i risultati del sito in analisi/promozione del cliente con quelli dei diretti concorrenti, riassumendone le posizioni e indicando per ogni concorrente quale sia il 'fronte di attacco' in cui risulti più facile inserirsi.

3) ordinando le keyword a seconda della loro posizione media otteniamo, orizzontalmente, la distribuzione a seconda della loro presenza che potrebbe essere assunta come indice di penetrabilità, essendo ovvio che per il concetto in analisi la keyword più a sinistra sarà quella su cui sarà più difficile inserirsi, mentre quella più a destra sarà quella in cui c'è meno competizione. In linea di massima, a livello di marketing mix online le parti a sinistra potrebbero essere veicolate verso il PPC e quelle a destra verso l'irrobustimento organico.

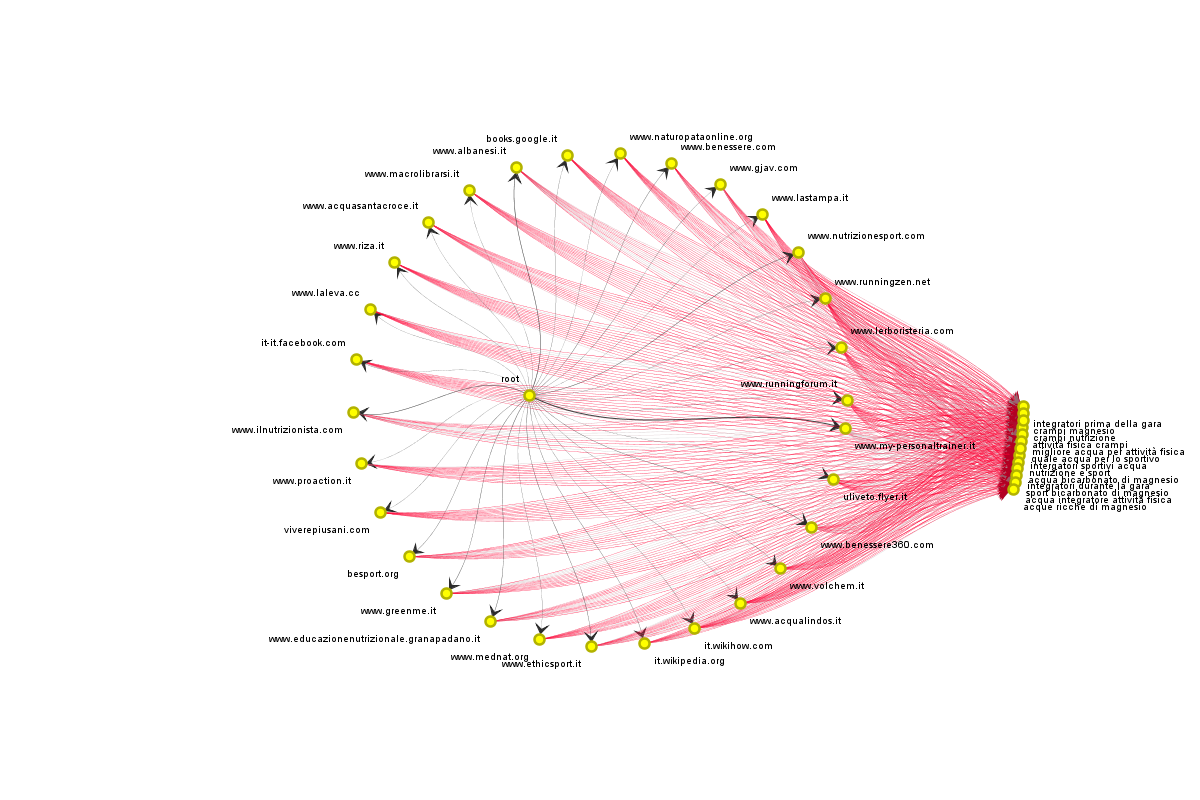

Spesso mi aiuto con grafici che possono dare, a livello visivo, una maggiore sensibilità alle differenze tra competitor. Ad esempio:

In questa grafica ogni sito si rivolge con un fascio di linee verso una keyword. I fasci che risultano più colorati saranno quelli più importanti, quelli più grigi avranno collegamenti meno 'forti'; il colore della linea infatti è proporzionale al numero di volte con il quale il sito appare collegato alla keyword, che sarà quindi rosso/robusto quando un sito si collega ad una keyword più di una volta, cioè se è presente più volte nella stessa SERP, mentre sarà grigio se il collegamento sarà presente una sola volta.

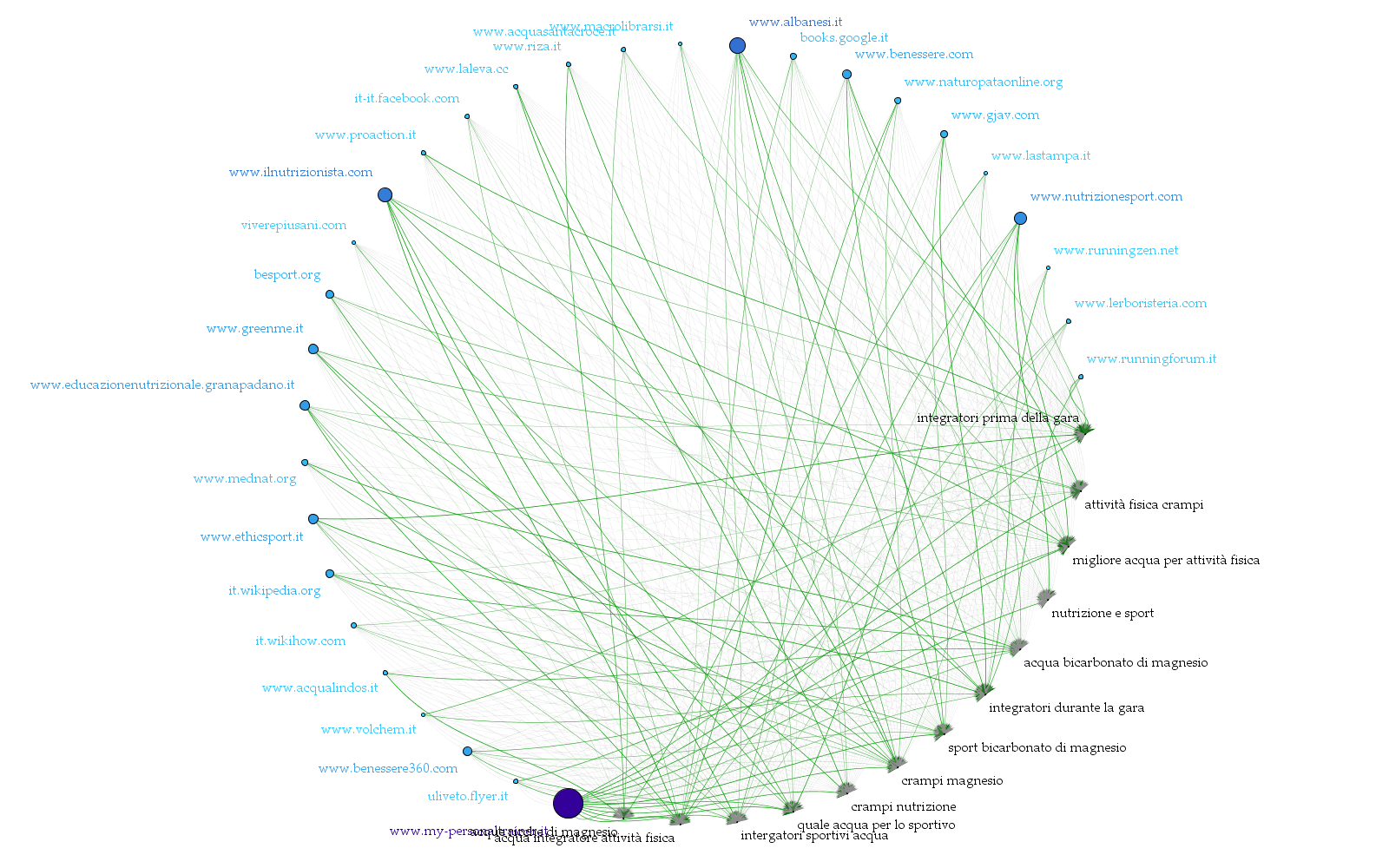

Gli stessi concetti possono essere espressi in modo visivamente diverso da:

In questo grafico si può anche apprezzare la relativa importanza delle keyword all'interno del concetto; le keyword nelle quali entrano più linee verdi (il grigio diffuso è la punta della freccia) sono quelle a cui fanno riferimento più siti. Nell'esempio sopra riportato 'nutrizione e sport' è una delle keyword meno gettonate.

A questo punto si può effettuare una analisi per verificare quali sono i siti che rispondono per il maggior numero di keyword. Siamo giunti ad un punto di fondamentale importanza, perchè i siti che rispondono per molte keyword rispondono per il concetto che abbiamo espresso attraverso di esse;

- da un punto di vista dell'analisi, ciò è utile per definire quali sono i veri concorrenti per il concetto in esame

- da un punto di vista, più importante per noi, della promozione SEO del sito del nostro cliente, assume importanza fondamentale verificare i dati di questi siti che rispondono al concetto, perchè in questo modo possiamo verificare quali siano le caratteristiche utili per il posizionamento.

Anche in questo caso porto un esempio, questa volta relativo alla ristorazione nella mia città (inserisco solo le prime 13 righe e ometto l'ultima colonna, con i posizionamenti esatti per le singole keyword):

Il primo risultato, per esempio, appare nella SERP per sette delle 11 keyword analizzate in questo caso.

Se lo scopo è quello di promuovere un ristorante per queste keyword, otteniamo le indicazioni:

- sull'importanza di apparire in guide autorevoli, e quali utilizzare (viamichelin, tripadvisor, guidatorino, torinotoday) e, di converso, quali altre invece non appaiono.

- sulla possibilità per il sito di un ristorante di apparire nelle prime posizioni per il concetto; infatti ci sono siti di singoli ristoranti

- sulle policy da attuare nello scrivere contenuti; vediamo infatti riportati contenuti specifici, per esempio quel pag=28 in un URL ci indica la pagina di un sito che è stata 'premiata' con una buona posizione per le keyword a destra. Copiare le buone pratiche non è certo peccato, magari integrandole con qualche accorgimento in più così da insidiare la posizione di un possibile concorrente.

Una prima conclusione

Semplici strumenti utilizzabili da chiunque possono consentire analisi anche molto sofisticate per un SEO 'sensato' che consenta di premiare chi ha buoni contenuti, o che consenta di creare dei buoni contenuti per chi vuole meglio posizionarsi.

Questa indagine è iniziale, e non è che il cappello introduttivo dell'analisi SEO completa che nella pratica professionale conduco ogni mese per i siti affidati alle mie 'cure SEO'.

I risultati di questa analisi sono integrati dai passi successivi sopra riportati: l'analisi lessicale del 'corpus' di documenti, l'analisi delle interazioni con i social network e l'analisi della 'forma' della rete dei collegamenti tra le centinaia di siti risultanti dall'analisi del concetto - analisi di rete particolarmente utile sia per individuare backlink utili e autorevoli, sia per verificare il posizionamento del proprio sito all'interno della galassia dei siti simili o collegati.

2 - Analisi lessicale del corpus di documenti

Una volta ottenute le SERP per le keyword, tutti gli URL ricavati - che mediamente sono almeno un migliaio - vengono utilizzati per scaricare tutte le pagine collegate, così da creare un 'corpus' di documenti sui quali eseguire analisi.Altri articoli in questa sezione del sito sono dedicati a queste analisi, ne riporterò qui solo qualche esempio proseguendo il filone delle ricerche prima presentate.

In questa sede vediamo le analisi condotte sulle singole keyword e quelle sugli argomenti o topics.

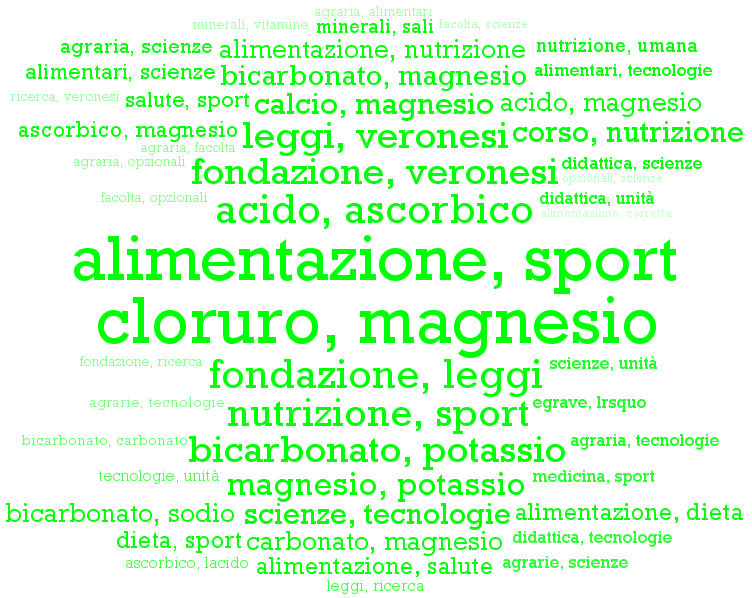

2a) Analisi sulle keyword nel corpus

Una prima sessione di analisi viene condotta sui termini utilizzati, analizzandone la frequenza e la co-occorrenza; ricordo che i dati sono ottenuti dai siti che risultano nella SERP quindi, soprattutto se il sito in analisi non vi è presente, servono per capire i termini che utilizzano i siti 'primi'. Nonostante che da questa analisi spesso vengano evidenziati naturalmente termini conosciuti e ricorrenti, è bene ricercare quali di questi NON sono presenti nelle pagine del sito in promozione per, eventualmente, integrarli. Normalmente rappresento in forma di cloud di parole le keyword trovate, in modo da percepirne immediatamente l'importanza:

L'indicazione è quanto mai importante per i white-hat SEO, in quanto indirizza, insieme alle indicazioni precedenti e quelle che vedremo più avanti, i copywriter / creatori di contenuti verso la realizzazione di pagine utili al posizionamento.

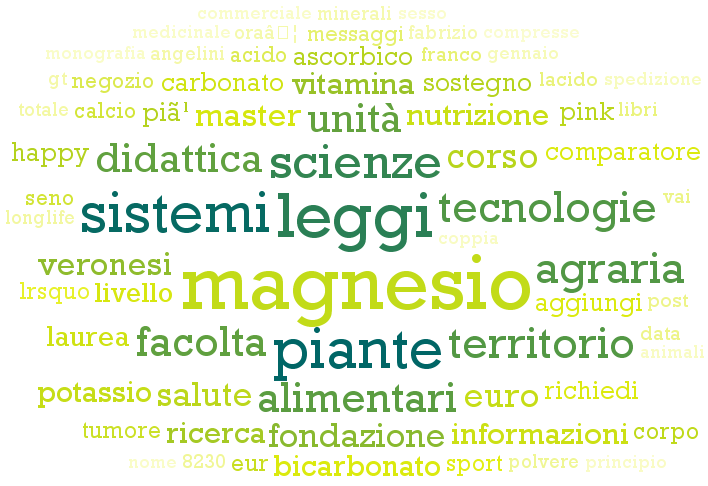

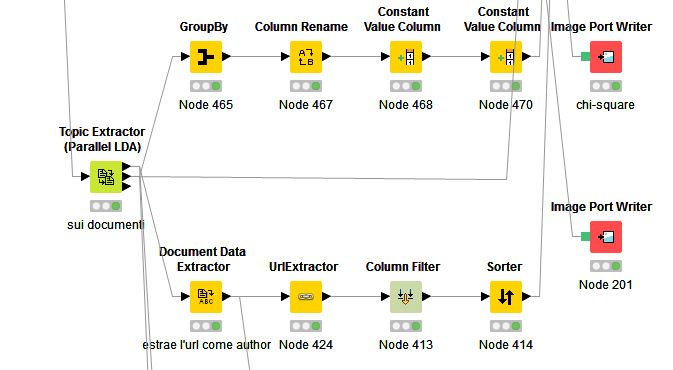

2b) Analisi sugli argomenti nel corpus

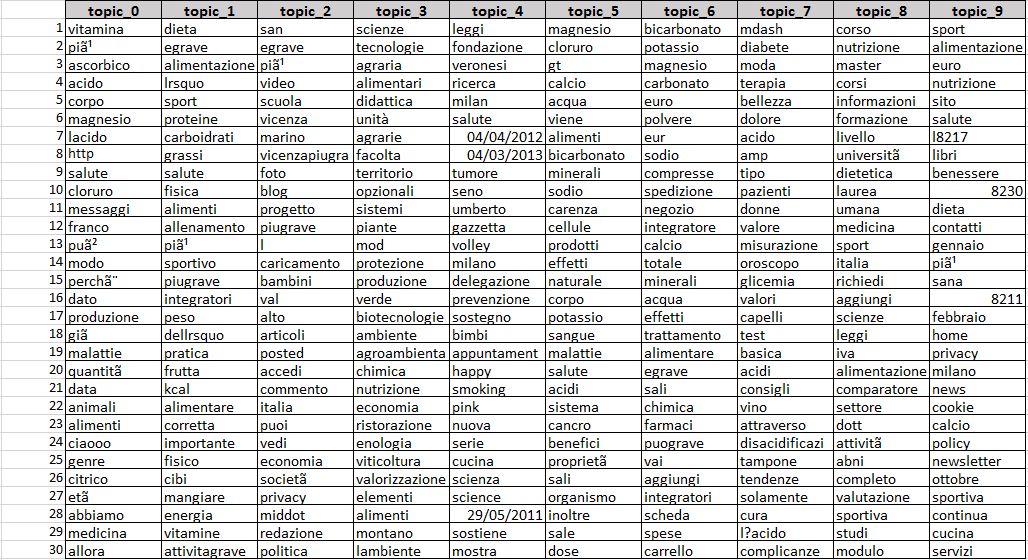

Gli argomenti o topics vengono ottenuti analizzando il corpus di documenti tramite l'algoritmo LDA (Latent Dirichlet Allocation): un metodo di analisi del linguaggio naturale che ipotizza in ogni documento un insieme di argomenti, e quindi li estrae definendoli con un insieme di parole. Utilizzerò qui il termine parole e non keyword per non confonderle, nonostante la sostanziale ambivalenza.Per l'analisi vengono definiti a priori il numero di argomenti da impostare e, per ogni argomento, il numero di parole che lo descrivono; in questo modo l'algoritmo troverà dieci argomenti trasversali a tutti i documenti nel corpus e ad ogni documento attribuirà un peso ad ognuno degli argomenti; in questo modo un documento potrà, per esempio, contenere sei argomenti su dieci e, per ognuno di questi sei, ne viene definito il peso.

Impostiamo l'analisi LDA per ottenere 10 argomenti o topics, ognuno descritto da trenta parole; dopo aver 'frullato' per un po' di tempo (sono analisi spesso time-intensive e soprattutto CPU-intensive) il sistema mi risponde con i dieci argomenti, ognuno descritto da trenta parole.

Ecco il risultato:

Molte delle keyword sono inutilizzabili e vanno eliminate.

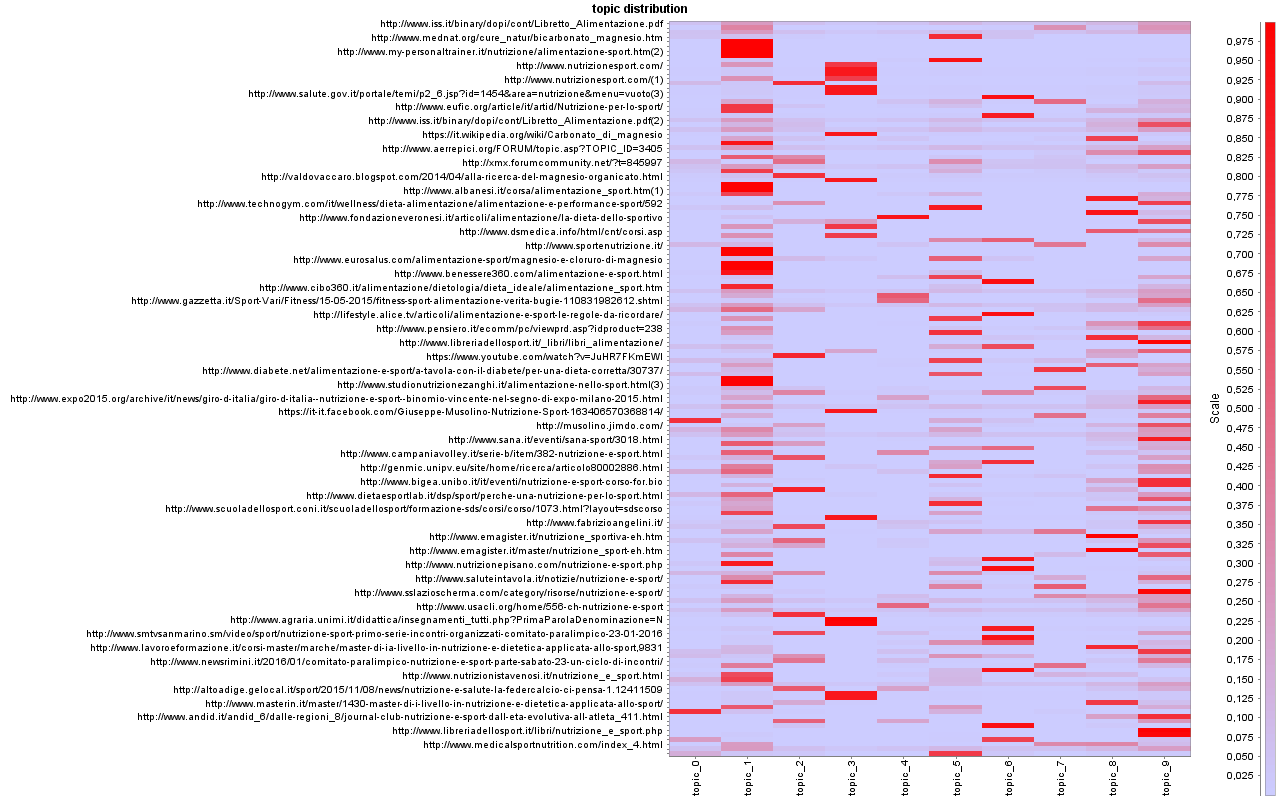

A questo punto è necessario procedere per scegliere quale dei topics potrebbe essere utile al nostro lavoro; per farlo cerchiamo il livello di probabilità di appartenenza di un topic ad un documento, livello che va da 0 a 1. Per evitare di mostrare una asettica tabella, i risultati li ordino per posizionamento medio dell'URL nella SERP, ne analizzo i primi 50 e visualizzo i dati come heatmap. Ecco il risultato:

Con questo tipo di visualizzazione possiamo:

- vedere quale sia il topic più diffuso tra i primi siti nella SERP; dove la colonna si fa più densa vuol dire che l'argomento è più presente

- tuttavia la differenza tra topic_1 e topic_9 deve essere notata: in un caso l'argomento è uniformemente diffuso, nell'altro è più presente nei siti nelle prime posizioni; potrebbe proprio essere questo il discrimere per decidere quale sarà l'argomento da veicolare verso la redazione di contenuti

- potremmo decidere di 'copiare' le buone pratiche di un sito vedendo per un URL ritenuto affidabile quali argomenti più utilizza.

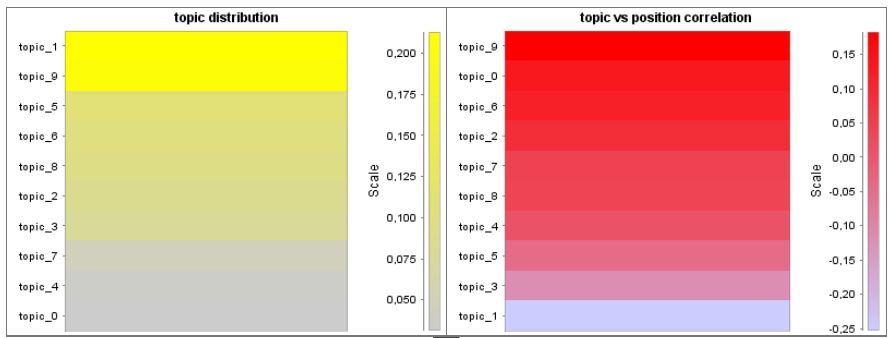

Analizzando le migliaia di URL ottenute, il grafico giallo indica quelle più presenti nel corpus di documenti, mentre quello rosso lo si è ottenuto calcolando la correlazione lineare tra topic e posizionamento del sito, e ci porta alle stesse conclusioni che avevamo ottenuto nella visualizzazione precedente: il topic_1 è il più diffuso mentre il topic_9 quello più vicino alle prime posizioni.

A questo punto possiamo decidere di veicolare verso la redazione di contenuti uno dei due topic, corredato dalle parole che lo descrivono, oppure entrambi; qui entra in gioco la capacità unica del gestore del sito e della sua conoscenza del mercato e dei clienti per individuare dalle parole una linea guida, un indice generale dei contenuti che everranno redatti. In mancanza di questo indice, lo si può redarre ex-novo oppure affidarsi ad uno dei siti che meglio risponde per quell'argomento, per copiarne le buone pratiche.

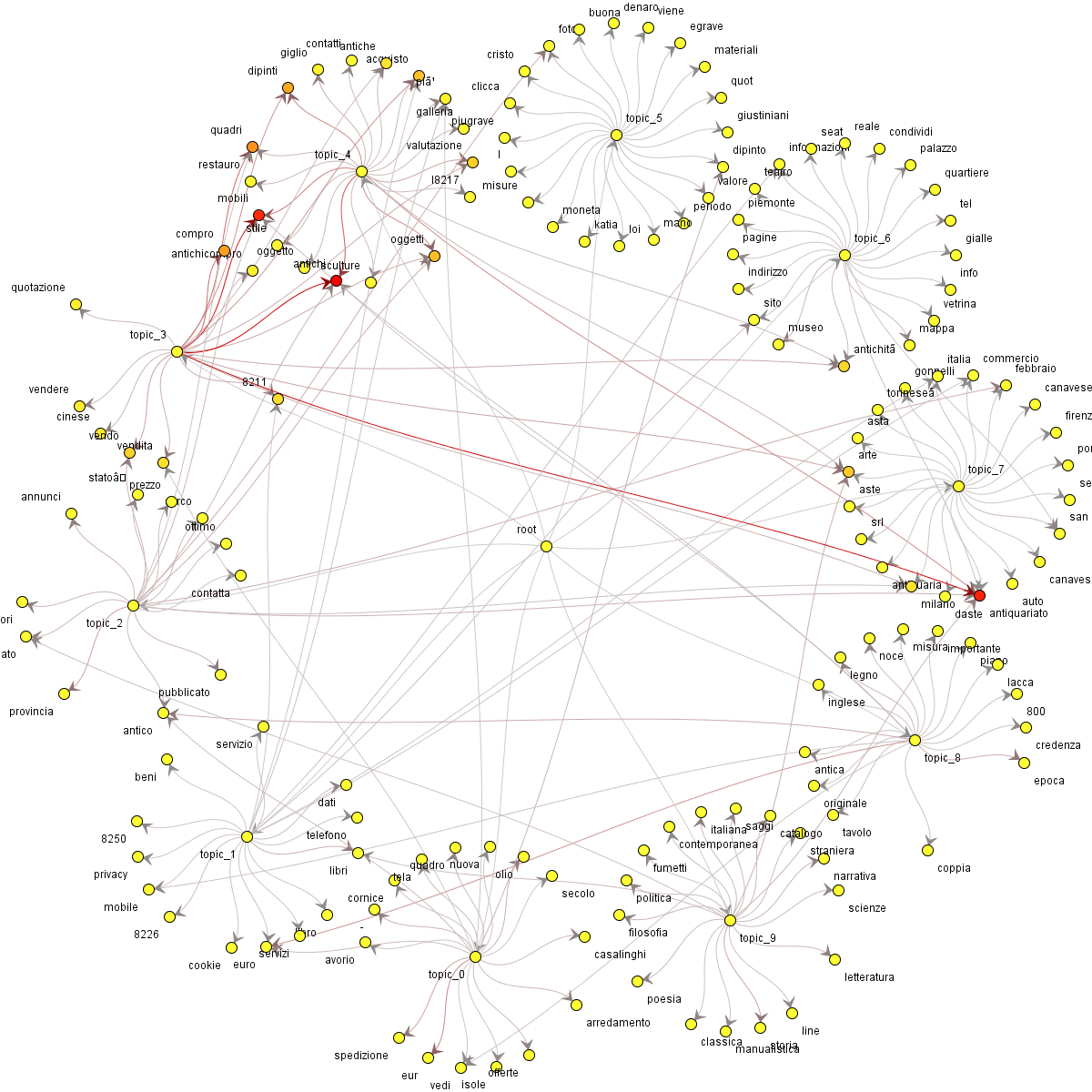

Verso la redazione di contenuti può essere veicolato anche un grafico a rete che riporti gli argomenti e le parole:

Una seconda conclusione

L'analisi lessicale ci consegna parecchi spunti da indirizzare alla redazione dei contenuti, sia per quanto riguarda le parole da considerare che gli argomenti da trattare.3 - Analisi delle correlazioni parametriche

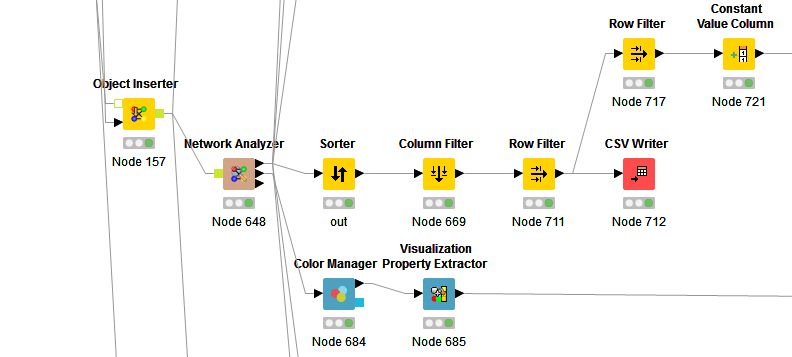

Combinando l'elenco di URL ottenuti e le analisi sul corpus possiamo eseguire ulteriori analisi cercando di definire, per ogni URL, un numero di parametri il più alto possibile in modo da utilizzarli per verificare se esista una correlazione tra tale parametro ed il posizionamento del sito.Oltre ai parametri finora utilizzati, ne cerchiamo altri; nel mio caso ho utilizzato una serie di script, API e funzioni di singoli programmi per raccogliere questi dati.

I parametri che infine vengono definiti per ogni URL sono:

Parametri relativi al contenuto

length

words

sentences

syllables

letters

h1

imagesNumber

keyInText

keyInTitle

keyInH1

linkKey

numKeyInLinkText

imageSrcKey

imageAltKey

imageTitKey

Parametri relativi alla leggibilità

indice di flesch

indice di gulpease

Parametri relativi ai social network

Facebook Likes

Facebook Shares

Facebook Comments

Facebook Likes+Shares+Comments

Google Plus Likes

Linked In Shares

Pinterest Pins

Parametri relativi ai link

Backlinks Domain

Backlinks Page

DMOZ Accepted

alexa value

Web of Trust Trustworthiness

https

Parametri riassuntivi

tot social

tot backlinks

tot content

Da questa analisi otteniamo una tabella che, per ogni URL, ci indica i dati; ne indico una parte, come esempio per la keywurd 'mindfulness':

A questo punto può essere ricercato il valore di correlazione per ogni keyword e per ogni parametro in funzione della posizione nella SERP; viene utilizzato l'indice di correlazione di Pearson per mettere in relazione il parametro con la posizione.

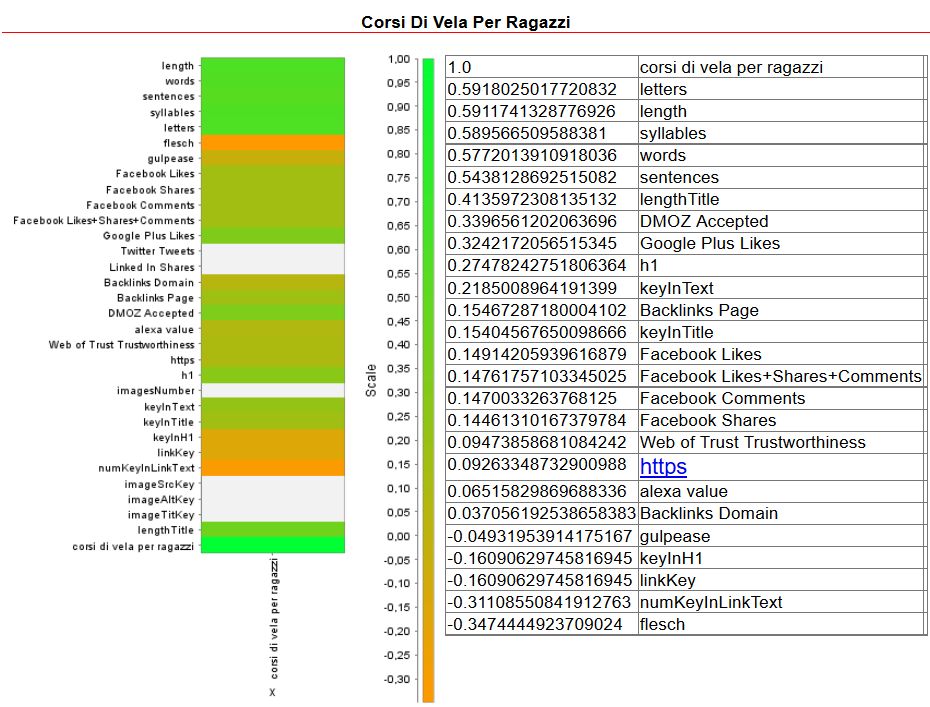

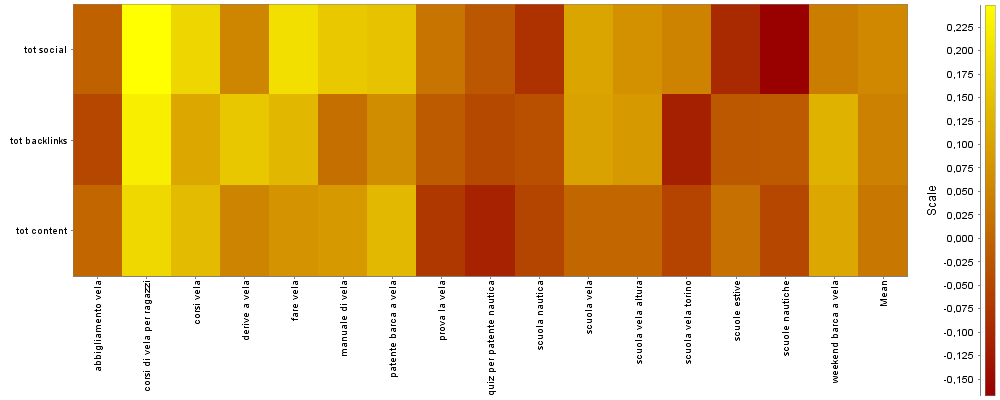

Per ogni keyword, quindi, può essere ricavato un insieme heatmap / dati di questo tipo:

La tabella indica, per valori decrescenti dell'indice di correlazione, il valore di correlazione ed il parametro. In questo caso per la keyword 'corsi di vela per ragazzi' il parametro che più direttamente è correlato con il posizionamento è 'letters', ovvero il numero di caratteri della pagina; subito dopo la lunghezza totale del documento, il numero di sillabe, parole e frasi, cioè tutto ciò che è correlato con la lunghezza della pagina è positivamente correlato; ciò significa che nel suggerire alla redazione dei contenuti come redarre gli articoli si punterà a richiedere articoli lunghi.

'Correlation is not causation', ricordo, i valori vanno presi con cura e redarre pagine lunghe non causa un buon posizionamento, ma possiamo dire che tutti quelli ben posizionati per questa keyword hanno pagine lunghe.

La heatmap visualizza per 'zone' l'importanza della correlazione; a partire dall'alto, parametri relativi alla lunghezza, leggibilità, social network, backlinks, composizione del testo/immagini. Normalmente non considero importanti valori di correlazione, per singola keyword, inveriori a 0.15.

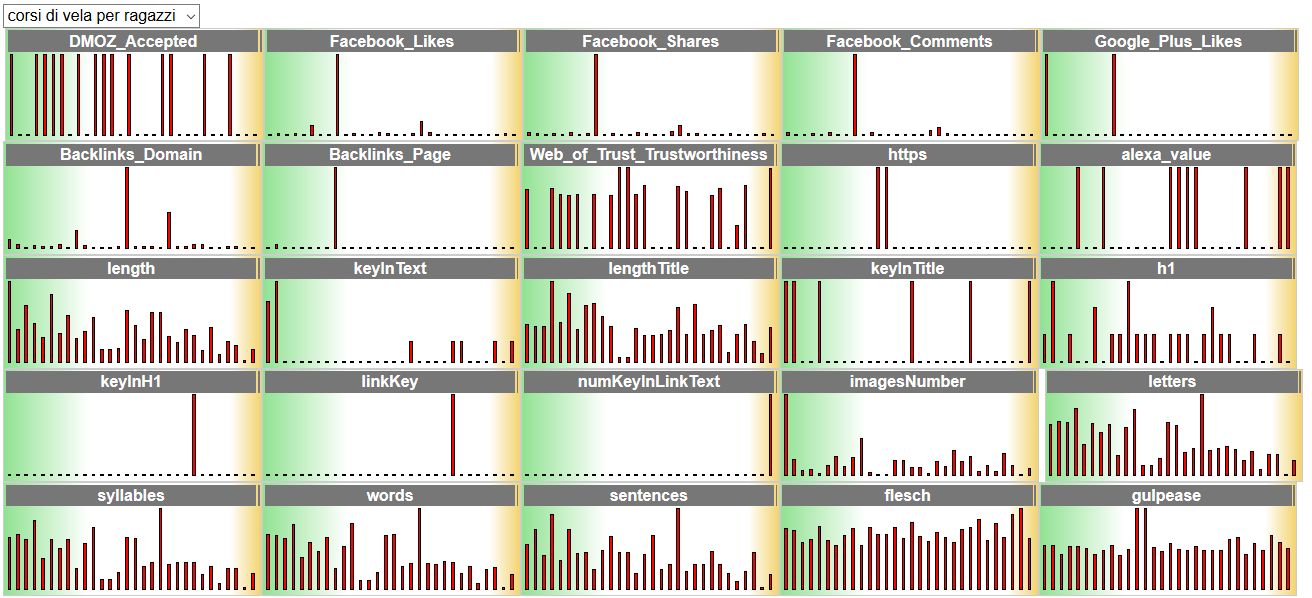

Nelle mie relazioni preparo inoltre una sezione dinamica che consenta i vedere graficamente l'andamento dei parametri per i singoli URL; ad esempio questo appare per la keyword appena vista:

- la keyword considerata viene selezionata dal select in alto;

- ogni grafico riguarda un parametro

- nel grafico da sinistra (parte verde) a destra (giallo) vengono visualizzati con barre i valori del parametro

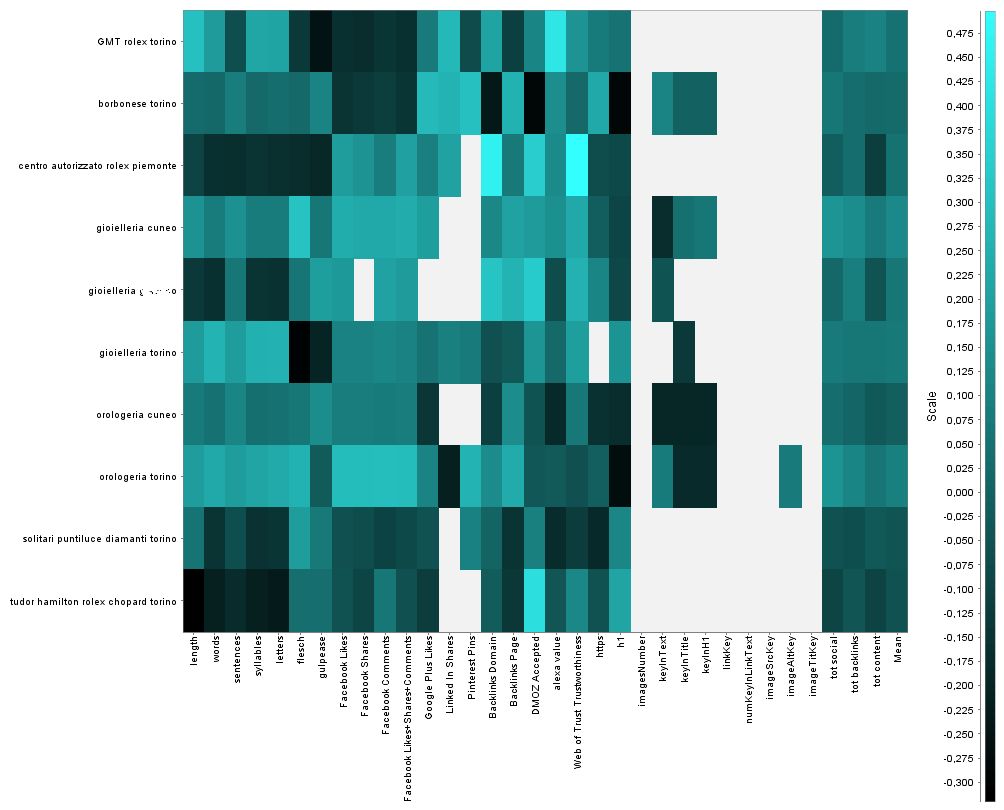

A questo punto per avere una visione di insieme possiamo creare una immagine globale che riguardi tutte le keyword che stiamo considerando in funzione di tutti i parametri:

In questo modo si ha una visualizzazione globale dei parametri correlati con il posizionamento del sito; dall'immagine riportata si può evidenziare l'importanza che ha Facebook nella correlazione con il posizionamento di 'orologeria torino' (i valori più chiari rappresentano correlazioni più spiccate), e simili analisi possono facilmente essere eseguite semplicemente osservando l'heatmap e stabilendo quali siano le azioni da mettere in atto.

Per poter mettere in evidenzia ancora più chiaramente le azioni da effettuare per il miglioramento della posizione, i parametri individuati vengono raccoli in tre grandi contenitori: quelli relativi al contenuto, ai backlinks e alle azioni social. In questo modo il grafico che si ottiene indica più chiaramente dove, e come, investire le risorse a disposizione; ecco un esempio:

Anche in questo caso a colori più chiari corrispondono correlazioni con la posizione più alte.

Per questo gruppo di keyword risulta chiaro che l'investimento prioritario dovrebbe essere sulla creazione di azioni social per 'corsi di vela per ragazzi', mentre non sembra altrettanto utile investire in azioni social per 'scuole nautiche'; con lo stesso criterio possono essere individuate per ogni tipo di intervento le keyword più adatte.

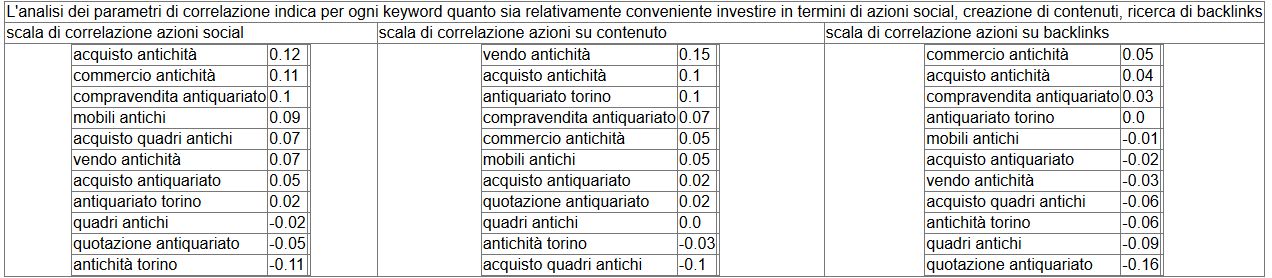

E' possibile creare 'scalette' di importanza per ognuno dei tipi di intervento; per esempio qui vedete tre scale di importanza a seconda dell'azione di miglioramento:

Si potrà in questo modo instradare chi si occupa di interventi social soprattutto su 'acquisto antichità', chi crea contenuti su 'vendo antichità' e la ricerca di backlinks su 'commercio antichità'. (Va rilevato, per correttezza, che il parametro di correlazione è in questo caso molto basso, inferiore o uguale a 0.15, quindi non si può essere certi che l'azione sortisca effetti chiari e immediati; valori più alti di correlazione renderebbero l'azione più sicura).

Concludendo... per la terza volta

L'analisi della correlazione dei parametri ci consegna una valutazione su come intervenire, differenziando l'entità degli interventi sulla redazione dei contenuti (sia sulla quantità di parole da utilizzare che sulla modalità con la quale implementarli), sulle azioni da svolgere sui social network, su quelle da direzionare invece alla ricerca di backlink, ai quali è dedicata l'analisi di rete successiva.4- Analisi dei link

Dall'analisi delle SERP per ogni keyword otteniamo una lista di link pari a numero di keyword x profondità di ricerca.

Ad esempio 11 keyword per una profondità di 80 producono 880 link.

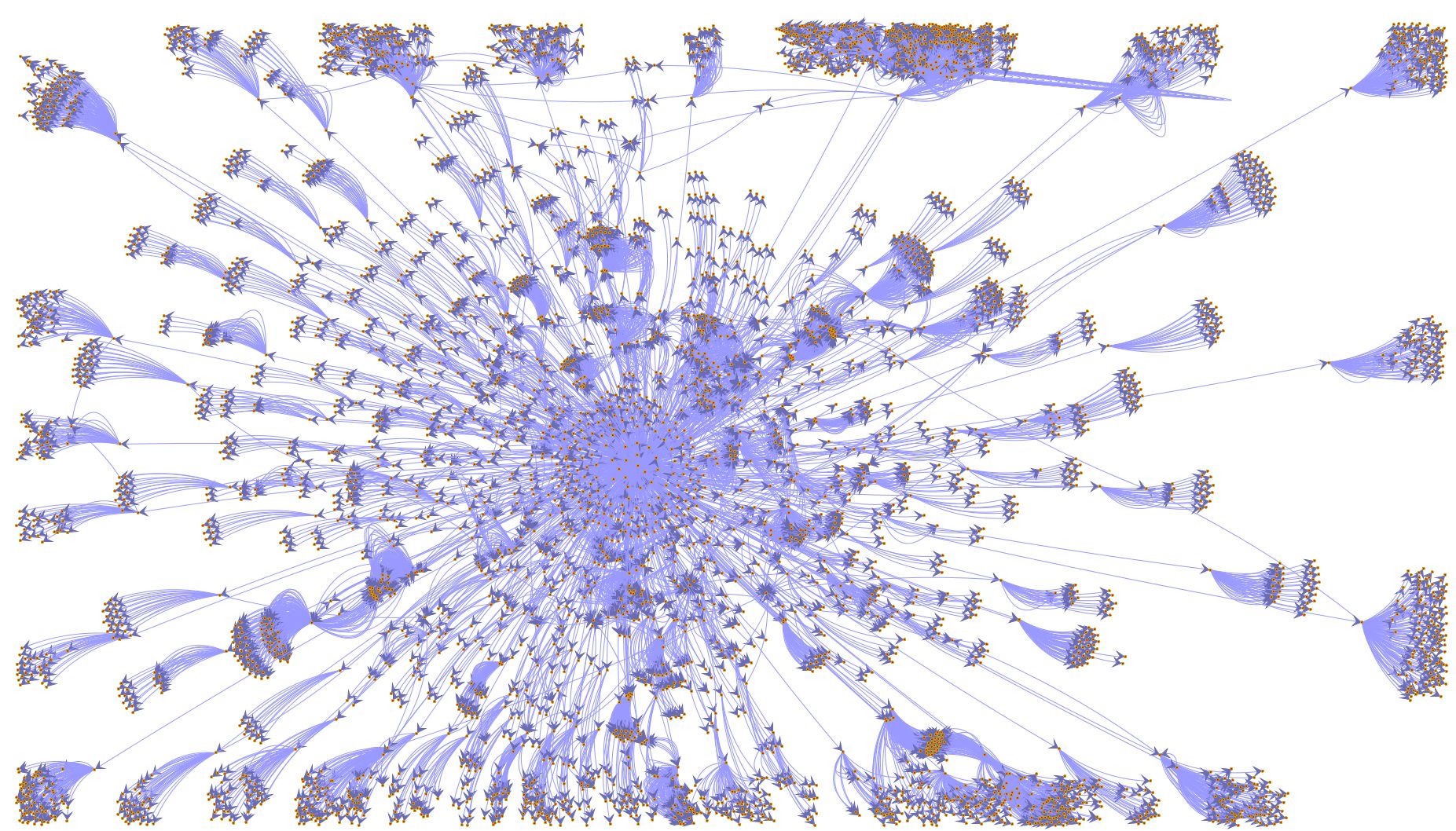

A questo punto entra in gioco un sistema che scandaglia tutte le 880 pagine e, all'interno di esse, cerca ogni possibile link verso l'esterno costruendo una rete di link che rappresentano la rete di conoscenza sottesa al concetto definito dalle keyword da parte di Google.

Questa rete può essere rappresentata e su essa possono essere eseguite analisi.

Questa specie di fuoco d'artificio indica come, da una ricerca centrale delle keyword, si 'salta' da un sito all'altro. Più questa rete è ramificata più indica una separazione netta tra le keyword; più possiede collegamenti tra rami più significa invece una intensa relazione tra i siti che parlano delle keyword.

Nella visualizzazione dinamica consegnata al cliente SEO, la rete è esplorabile, evidenziando i nomi di ogni nodo.

Su questa rete possono essere eseguite alcune utili analisi, tra queste vedremo la frequenza di dominio, di URL, la quantità di relazioni da e verso un sito, la centralità di rete e l'autorità di dominio. Queste analisi ci saranno utili per analizzare quali link possono esserci utili perchè il nostro sito abbia referenze positive in rete.

Le prime due analisi semplicemente analizzano la quantità di link presenti.

Prendendo ad esempio una analisi relativa al concetto 'abbigliamento per bambini', la ricerca ha restituito 578 pagine web; analizzando le pagine, sono stati trovati 6544 links.

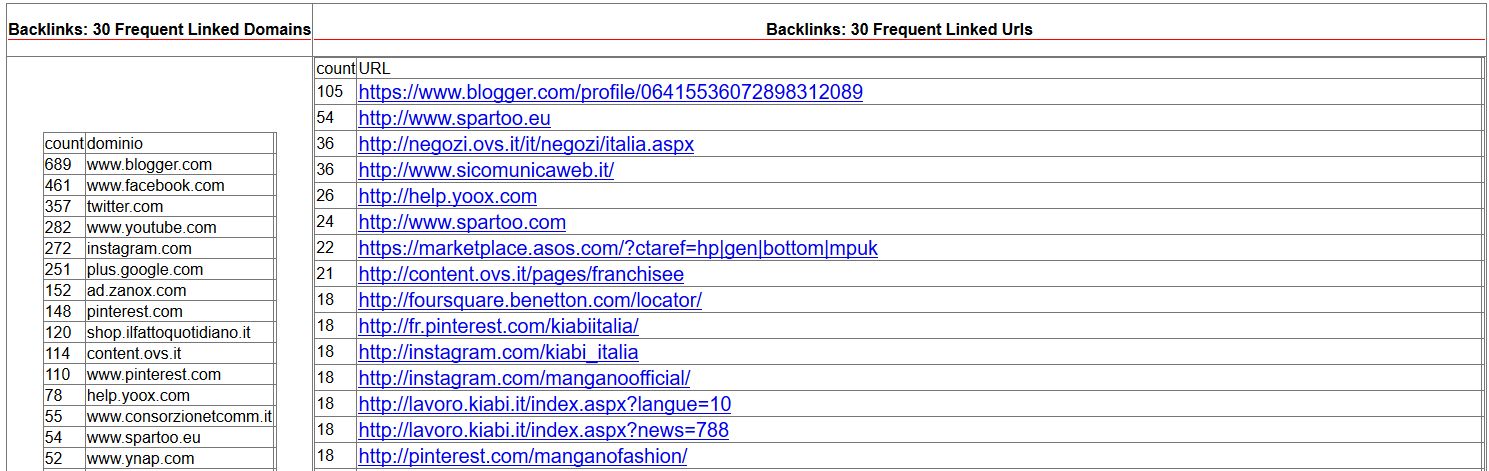

Tra questi, i domini e gli URL più frequenti (tabella tagliata ai primi valori):

La tabella a sinistra presenta i domini più frequenti, quella a destra le pagine.

Si nota la frequenza quasi ossessiva dei social network, in cui si deve essere presenti e si nota altrettanto, a destra, che un blogger viene molto frequentemente ad essere presente nei link.

E' questa una risorsa preziosa, sia perchè inserendo interventi in quel blog il proprio intervento viene riverberato positivamente nella rete dei siti relativi al concetto che ci sta a cuore, sia perchè si potrebbero chiedere interventi mirati al blogger in questione sull'argomento.

La tabella ci fornisce comunque preziose indicazioni sugli operatori presenti sul mercato e sulle zone nelle quale andare a 'pescare' per ottenere utili backlinks.

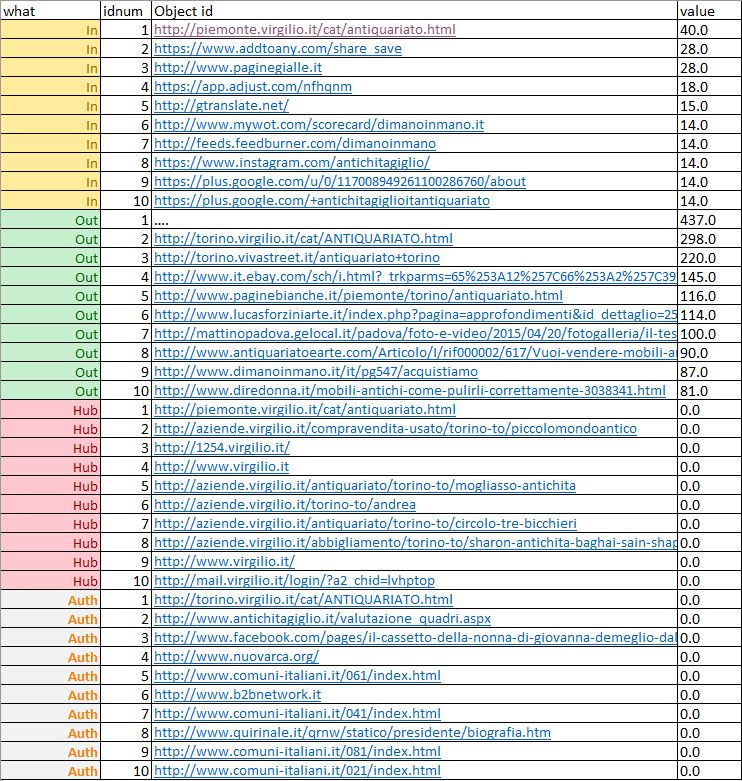

A questo punto sulla rete possono essere eseguite alcune operazioni di analisi più specifiche, in particolare:

- IN, analisi dei nodi di rete che ricevono link dall'esterno, indicano le risorse spesso linkate, utili per avere riferimenti alla conoscenza in rete; allo stesso tempo indicano risorse che, se linkate, indicano a Google che il nostro sito ha buoni link verso l'esterno

- OUT, siti che hanno molti link verso l'esterno, utili per ospitare anche un backlink per il nostro sito

- HUB, siti che hanno una centralità nella rete, che spesso possiedono liste di link verso risorse autorevoli

- AUTH, siti autorevoli, cioè con link verso risorse HUB

Una quarta, e ultima conclusione

Con questa quarta parte, si conclude l'analisi dell'argomento indicandoci le risorse di rete verso le quali, o dalle quali, ottenere link verso il sito in promozione.L'insieme dei quattro paragrafi affrontati in questo articolo consente da una parte l'analisi puntuale, dall'altra di impostare le azioni per la promozione SEO.

Nella pratica condotta con i clienti, questo tipo di analisi costituisce la seconda parte della relazione mensile; la prima riguarda lo stato dell'arte del sito così come monitorato da Google Analytics, Google Search Console, Moz Analytics, e da alcuni strumenti proprietari.

L'intera relazione consta di circa una trentina di pagine e si conclude con l'elenco delle azioni da mettere in atto per la promozione del sito; a volte vengono svolte a cura del cliente, a volte è la stessa azienda che consegna la relazione che si occupa anche degli interventi di promozione.

A conclusione dell'articolo e a conferma della validità dell'approccio, non possono che essere i numeri.

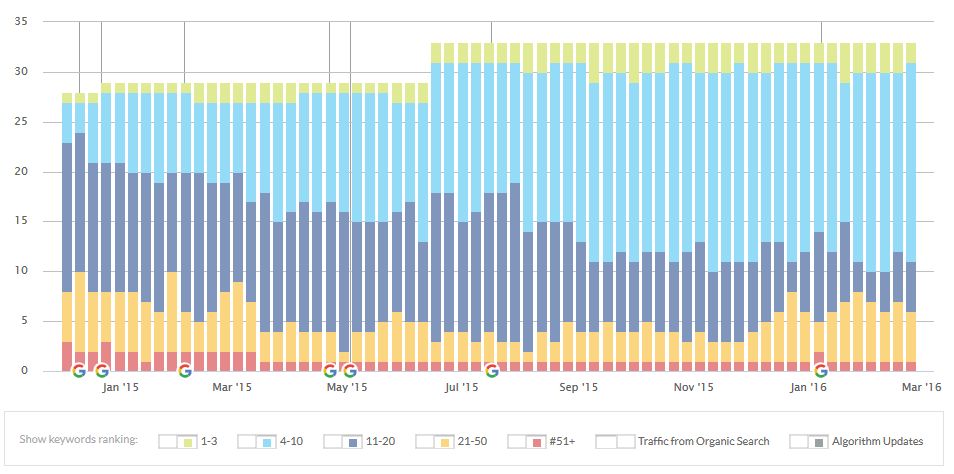

Cito l'esempio di un sito sotto le mie cure da un paio d'anni, per il quale riporto due grafici che, spero, siano esaustivi del lavoro svolto.

Il primo ripreso da Moz, indica nel tempo l'azione di 'conquista della prima pagina' da parte delle keyword:

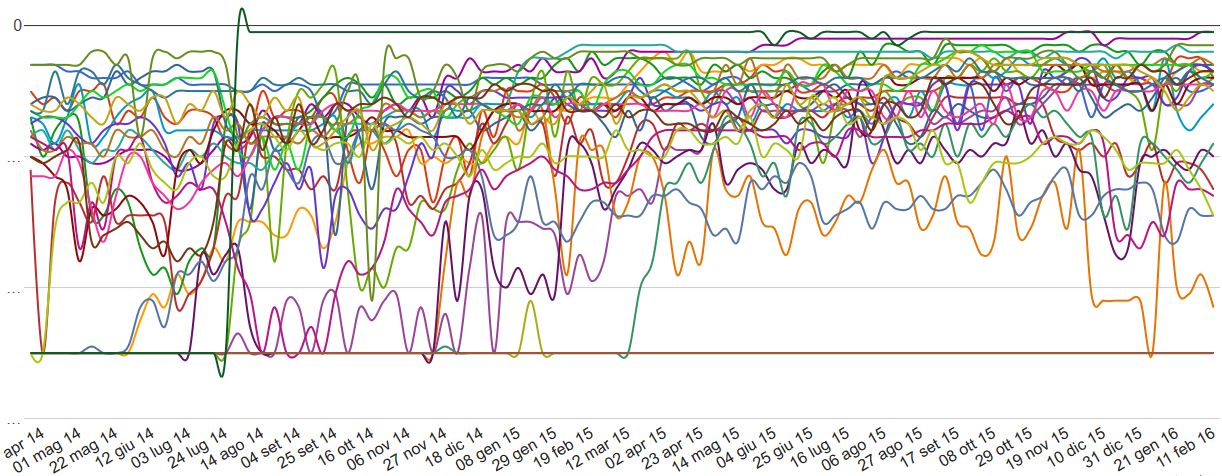

In questo secondo grafico, l'andamento storico delle singole keyword, per lo stesso sito:

Qui si vede il fascio delle keyword che, nel tempo, si spinge verso le prime posizioni.

Linkografia

https://en.wikipedia.org/wiki/Chi-squared_testhttps://en.wikipedia.org/wiki/Latent_Dirichlet_allocation

http://www.linkomm.net/SEO-e-leggibilita-delle-pagine/page_143.html

https://it.wikipedia.org/wiki/Indice_di_correlazione_di_Pearson